Tecnológica continua a alargar a integração do sistema conhecido como modelo unificado multitarefa (MUM) para criar novas formas de interação entre os utilizadores e as ferramentas de pesquisa

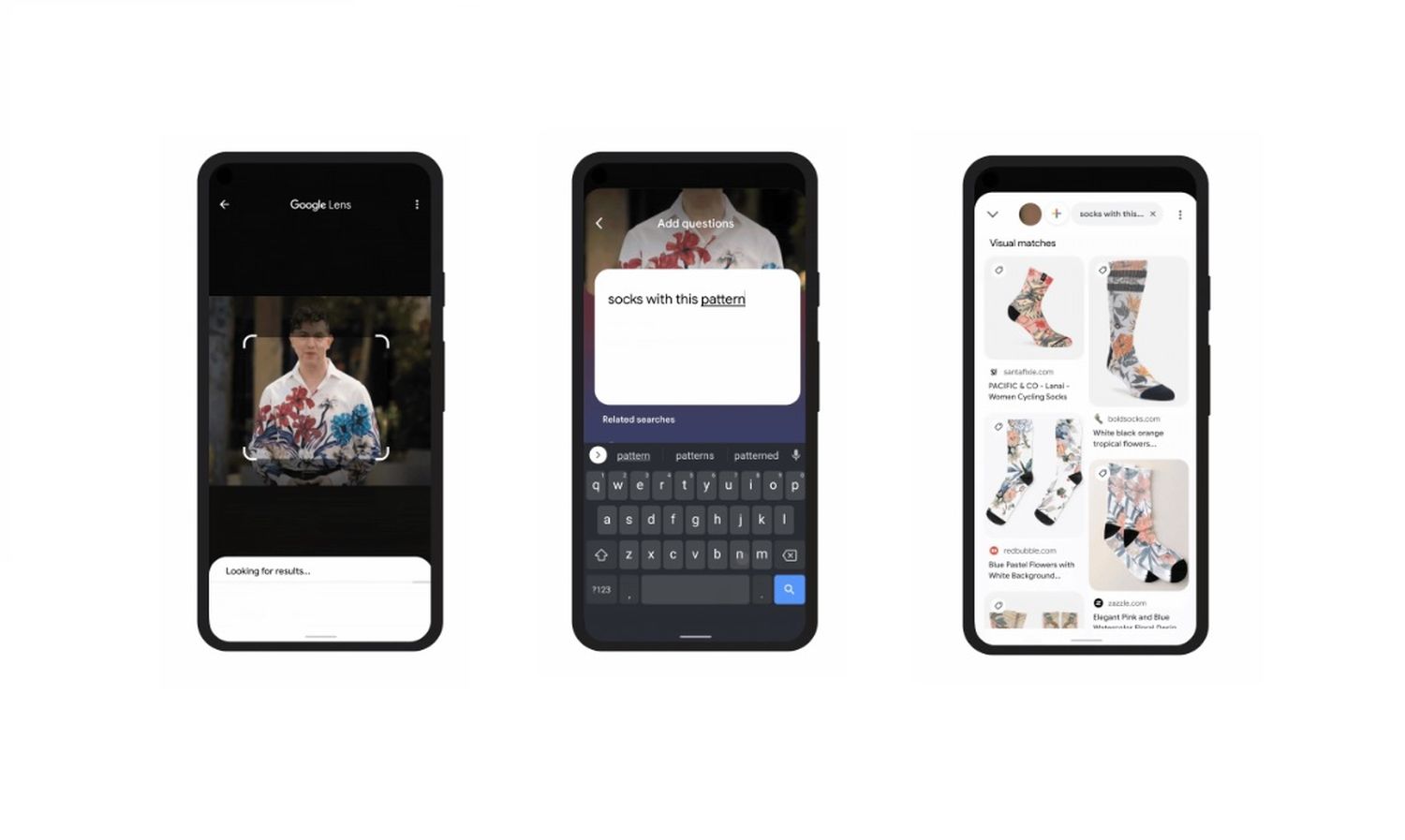

A Google vai lançar uma atualização para a ferramenta de pesquisa visual Lente (Google Lens, em inglês) que permite aos utilizadores fazerem pedidos por escrito tendo por base uma fotografia ou imagem. Num dos exemplos dados pela tecnológica, será possível a partir de uma fotografia de uma camisa com padrão pedir ao motor de busca para nos mostrar meias com padrões semelhantes. Ou num outro exemplo, tirar uma fotografia à correia de uma bicicleta e depois perguntar, por escrito, como é que se pode fazer o arranjo daquele elemento.

Isto é possível graças ao modelo unificado multitarefa (MUM), a tecnologia apresentada em maio e que, aos poucos, tem permitido aumentar as capacidades das ferramentas de pesquisa da Google. Uma das características desta tecnologia é a chamada capacidade “multimodal”, ou seja, a capacidade de perceber e relacionar texto, imagem e vídeo.

“Podes perguntar ao Lente sobre coisas que estás a ver. É a primeira vez que vais poder combinar texto e imagem juntos [em pesquisa]. Podes fazer uma captura de ecrã e pedir ao Google para encontrar algo com aquele padrão”, explicou Nishant Ranka, gestor de produto na tecnológica americana, numa apresentação antecipada das novidades e na qual a Exame Informática participou. “Quando aplicamos o MUM à pesquisa, criamos experiências mais úteis”, sublinhou o responsável.

Outros exemplos do que vai ser possível fazer com o novo sistema: tirar uma fotografia de um pássaro e perguntar qual o seu habitat ou o que come; ou então tirar uma fotografia a um azulejo e pedir ao Google para encontrar lençois com aquele padrão. “Os utilizadores vão usar este sistema para se expressarem sobre coisas que são difíceis expressar por palavras e isso vai ajudá-los a encontrar novos produtos na internet”, detalhou ainda Nishant Ranka.

Apesar do anúncio feito, a Google diz que esta funcionalidade ainda irá demorar “meses” até ficar disponível. Mas há outras novidades a caminho.

Partindo do motor de aprendizagem mais poderoso do MUM, os utilizadores vão passar a encontrar mais imagens nos resultados de pesquisas quando a resposta deve ser mais focada em elementos visuais – como procurar por métodos de pintura, por exemplo. E a Google vai também começar a mostrar resultados específicos de conteúdos que existem dentro de vídeos – ou seja, não reencaminha o utilizador apenas para o vídeo no YouTube, encaminha o utilizador para o momento exato naquele vídeo que acha que poderá responder à pesquisa feita.

Uma outra funcionalidade que tira partido do MUM, mas que só vai estar disponível nos EUA por agora, é a possibilidade de comprar produtos diretamente a partir da Lente Google: basta fazer o reconhecimento visual de uma peça de roupa ou mobiliário para que apareça na parte inferior do ecrã os links que levam o utilizador para a loja online daquele produto.

Por fim, a Google vai também dar mais contexto às pesquisas feitas pelos utilizadores, que vão ter a hipótese de explorar mais o ‘porquê’ de determinados resultados de pesquisa. Se escolher saber mais sobre aquele resultado, a Google vai mostrar informação sobre a fonte e mais dados sobre aquele tópico em específico, com o objetivo de aumentar a transparência e confiança nos resultados que aparecem online.

Comentários

Enviar um comentário